- Autor Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:44.

- Naposledy změněno 2025-01-22 17:21.

Příjem dat je proces získávání a importu data pro okamžité použití nebo uložení do databáze. Něco spolknout znamená „něco přijmout nebo něco absorbovat“. Data lze streamovat v reálném čase popř požití v dávkách.

Také víte, co je kanál pro příjem dat?

Potrubí příjmu dat . A kanál pro příjem dat přesuny streamování data a dávkově data z již existujících databází a data sklady do a data jezero. Pro HDFS založené data jezero se používají nástroje jako Kafka, Hive, nebo Spark příjem dat . Kafka je populární příjem dat nástroj, který podporuje streamování data.

Kromě toho, jak Hadoop přijímá data? hadoop používá distribuovaný systém souborů, který je optimalizován pro čtení a zápis velkých souborů. Při psaní do HDFS , data jsou „rozřezány“a replikovány napříč servery v a hadoop shluk. Proces dělení vytváří mnoho malých podjednotek (bloků) většího souboru a transparentně je zapisuje do uzlů clusteru.

Za druhé, co jsou nástroje pro příjem dat?

Nástroje pro příjem dat poskytují rámec, který umožňuje společnostem shromažďovat, importovat, načítat, přenášet, integrovat a zpracovávat data ze široké škály data prameny. Usnadňují data extrakční proces podporou různých data transportní protokoly.

Jak rozumíte příjmu a integraci dat?

Příjem dat je a proces přijímání dat z jednoho systému do druhého. Integrace dat umožňuje různé data typy (jako např data sady, dokumenty a tabulky), které mají být sloučeny a používány aplikacemi pro osobní nebo obchodní procesy.

Doporučuje:

Jaké procesy se používají ke zjištění trendů ve velkých souborech dat?

Zdrojová data musí projít procesem zvaným data staging a musí být extrahována, přeformátována a poté uložena v datovém skladu. Jaké procesy se používají ke zjištění trendů ve velkých souborech dat? Data mining se používá k analýze velkého množství dat, která pomáhá identifikovat trendy

Jaká je role analytika velkých dat?

Analytici velkých dat jsou zodpovědní za využití analýzy dat a CRM k vyhodnocení technického výkonu organizace a poskytování doporučení ohledně vylepšení systému. Tito analytici se mohou zaměřit na otázky, jako je streamování a živá data a migrace dat

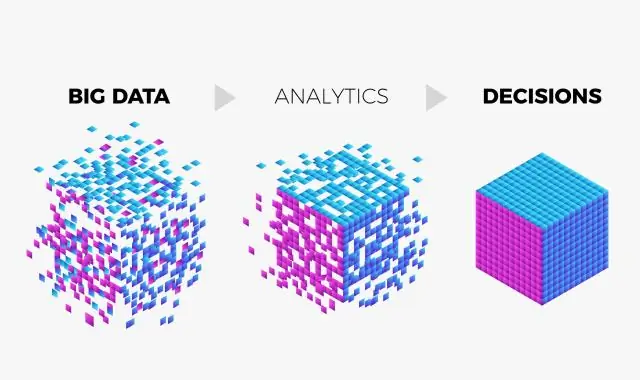

Jak byste definovali analýzu velkých dat?

Analytika velkých dat je často složitý proces zkoumání velkých a různorodých souborů dat neboli bigdata za účelem odhalování informací – jako jsou skryté vzorce, neznámé korelace, trendy na trhu a preference zákazníků – které mohou organizacím pomoci činit informovaná obchodní rozhodnutí

Co je Impala ve velkých datech?

Impala je open source masivně paralelní zpracování dotazů na klastrových systémech, jako je Apache Hadoop. Byl vytvořen na základě papíru Dremel společnosti Google. Jedná se o interaktivní dotazovací stroj podobný SQL, který běží nad Hadoop Distributed File System (HDFS). Impala používá HDFS jako své základní úložiště

Jaký je případ použití ve velkých datech?

Ačkoli se většina případů použití velkých dat týká ukládání a zpracování dat, pokrývají několik obchodních aspektů, jako je zákaznická analýza, hodnocení rizik a detekce podvodů. Každý podnik tak může najít relevantní případ použití, aby uspokojil své konkrétní potřeby